Dify部署人工智能应用

如今人工智能大模型(Large Language Model, LLM)的功能已经很强大了,但如何利用大模型来开发一些应用,提高自己工作的效率呢?

Dify是一款开发人工智能大模型应用的引擎,可基本不用代码的情况下开发出功能强大的大模型应用,如客服机器人、智能搜索、智能工作流等。由于Dify提供了开源的版本,不花任何的费用下实现本地的部署。

安装Dify开源版本

可参考官方Dify装指导,建议使用Docker进行安装,会简单很多。不同系统的安装Docker的方式稍微有些区别,务必看官方Docker安装指导,确保硬件与软件满足基本的要求。安装好Docker App之后一定要运行Docker,这样在Mac的终端或者Windows的PowerShell可运行Docker的指令。具体的指令如下,可通过官网或者Chat GPT了解每个指令的作用:

# Clone the Dify source code to your local machine:

git clone https://github.com/langgenius/dify.git

# Navigate to the Docker directory in the Dify source code

cd dify/docker

# Copy the environment configuration file

cp .env.example .env

# Start the Docker containers

docker compose up -d

# Check if all containers are running successfully:

docker compose ps

# 通过以下链接访问后台

http://localhostdocker compose up -d可能会出现以下报错:

% docker compose up -d

[+] Running 9/9

✘ redis Error context canceled 2.6s

✘ weaviate Error context canceled 2.6s

✘ nginx Error context canceled 2.6s

✘ db Error context canceled 2.6s

✘ ssrf_proxy Error context canceled 2.6s

✘ web Error context canceled 2.6s

✘ api Error Get "https://registry-1.docker.io/v2/": EOF 2.6s

✘ worker Error context canceled 2.6s

✘ sandbox Error context canceled 2.6s

Error response from daemon: Get "https://registry-1.docker.io/v2/": EOF这种情况是镜像拉取出错,是网络的问题。解决方法是在dify/docker的目录下新建一个配置文档,然后添加一些镜像备用网站。具体的操作如下

# Create daemon.json file in dify/docker directory

vim daemon.json

# Click [i] key to enter insert mode of editor

# Copy and pase following text in daemon.json file

{

"registry-mirrors": [

"https://2a6bf1988cb6428c877f723ec7530dbc.mirror.swr.myhuaweicloud.com",

"https://docker.m.daocloud.io",

"https://hub-mirror.c.163.com",

"https://mirror.baidubce.com",

"https://your_preferred_mirror",

"https://dockerhub.icu",

"https://docker.registry.cyou",

"https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc"

]

}

# Clikc [ESC] key to exit Insert mode of vim editor and then input [:wq] to save the file and exit the vim editor

如果不想用Docker部署,官方还提供了源代码部署,但会稍微复杂一些。

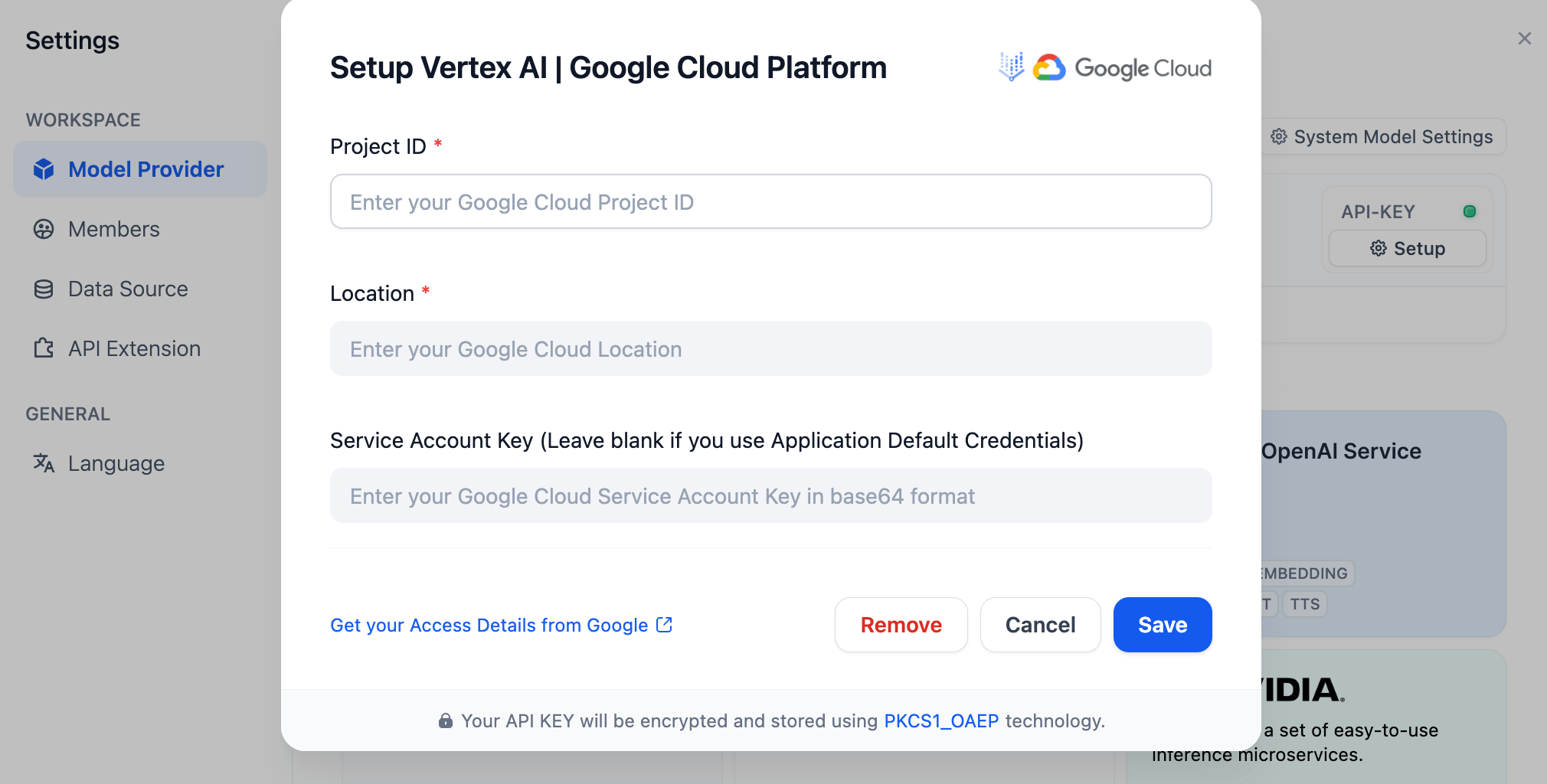

选择模型

同样参考官网模型设置的章节。进入设置可以选择不同的模型,Open AI、Gemini等是收费的,Ollama是开源的。可以根据自己的需求选择大模型。以添加Google Vertex AI为例,在模型列表中选择相应的模型,然后弹出以下设置的窗口。只需要输入相应的信息便可以添加大模型,后期应用的时候只需要选择相应的模型。

需要注意Google Cloud的Service Account Key是json格式,需要通过工具转成base64的格式。操作其实很简单,把json文档里的内容全部拷贝到在线转换工具,后期把结果拷贝到设置里面。

如果需要通过Ollama来下载并运行本地模型,可通过官网的模型列表找到需要的的模型。以下载llama3.2 3B的模型为例,只需要运行以下命令就可运行:

ollama pull llama3.2如果需要了解ollma相关的命令,只需要输入ollma -h。如何添加Ollama本地大模型需要认真看官方指导。本地大模型对机器的性能有要求,性能不够经常会报错。知识库的嵌入模型实测用本地的会快很多,API的运行特别慢。

http://host.docker.internal:11434 to access the service.添加数据库

如果应用需要用到知识库,还可以添加私有的知识库。添加Knowledge Base的操作就更简单了,只需要把文档加入到创建的数据库便可以,完全是图像界面的操作,不涉及任何代码。有一项需要注意的是选择Embedding Model,Ollama也提供了免费的本地部署的模型。

添加数据库最常遇到的问题是上传的文档一直显示排队(Queuing)状态,不管多长时间都不被处理,而且进度也总是0%。这是一个已经解决的问题,只需要在dify/docker文件夹下面的.env文件修改成如下:

# ------------------------------

# Server Configuration

# ------------------------------

# The log level for the application.

# Supported values are `DEBUG`, `INFO`, `WARNING`, `ERROR`, `CRITICAL`

LOG_LEVEL=INFO

# Log file path

LOG_FILE=/app/logs/server.log

# Log file max size, the unit is MB

LOG_FILE_MAX_SIZE=20

# Log file max backup count

LOG_FILE_BACKUP_COUNT=5

# Log dateformat

LOG_DATEFORMAT=%Y-%m-%d %H:%M:%S可以网络查找如何通过Bash的命令修改文件。

添加数据库最重要的一点是设置Chunk Method。不同的文件分割方式是不一样的,这个直接决定的问答的效果。If you want to split a Markdown document into chunks using ## (H2 headers) as delimiters, you can use the following regular expression: ##\s*

##: Matches the literal characters "##" which represent an H2 header in Markdown.\s*: Matches zero or more whitespace characters (spaces, tabs, newlines) that might follow the "##". This ensures that even if there are spaces after the header, it will still be recognized as a delimiter.

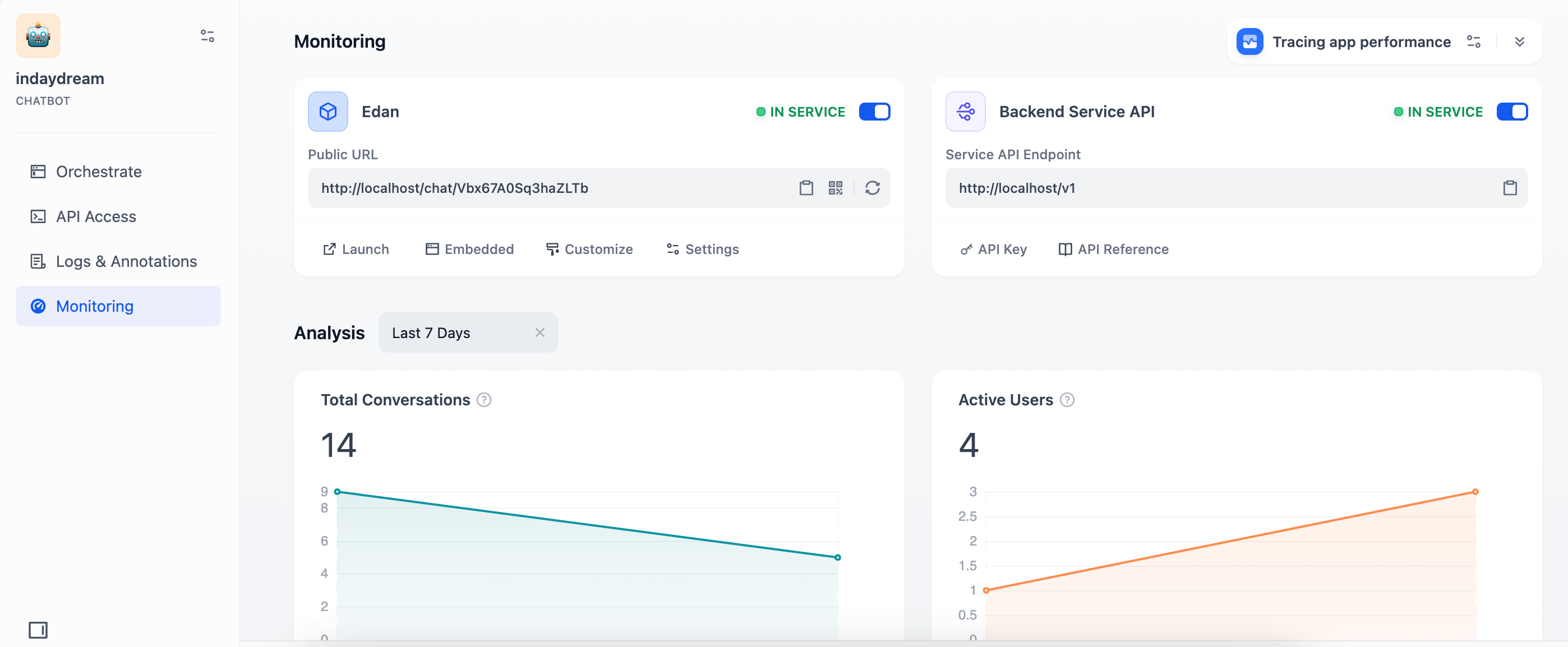

创建应用及发布

通过http://localhost进入后台之后,我们可以在Studio里面创建Chatbot,Agent,Workflow等多种应用。应用发布之后,可以在Monitoring中看到应用的所有情况。

由于是本地部署,所有以网址都是localhost。为了能让外网也能访问发布的APP及API,可以用到ngrok的服务。ngrok是一款开源的网络服务工具,主要用于实现内网穿透,即内网的服务可以被外网访问。通过ngrok穿透之后,api的地址就会变成公网的地址,任何人都可以访问。如果无法访问ngrok,可以找一些类似的服务,如cloudflare Tunnel。